Первая часть тут //infostart.ru/1c/articles/2382908/

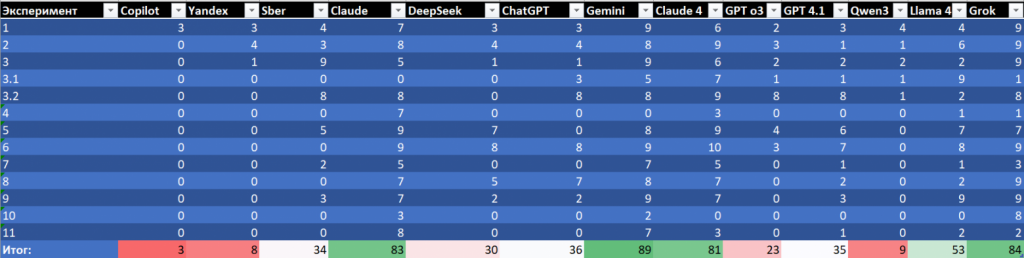

В обзор добавил Claude Sonnet 4, GPT o3 и 4.1, Qwen3, Llama 4 Maverick, Grok.

Мир меняется динамично. Отдельную LLM Arena для 1С-ного кода, наверное, делать смысла нет, но периодически информация обновляется.

Если для ЯП общего назначения информацию о наиболее крутых моделях найти не составляет труда, то для 1С мой "кустарный бенчмарк", кажется, пока лучшее, что можно обнаружить.

Принцип, по которому выбрал, всё тот же: LLM Arena + Статистика OpenRouter.

Эксперименты подробно описал в предыдущей статье, поэтому отдельно останавливаться не буду.

Для тех, кто не любит читать, табличка со сравнением в начале:

Одну сеть пришлось исключить, несмотря на то, что я обещал.

Sber GigaCode - мне его рекомендовали в комментах к прошлой статье, и я обязательно обещался попробовать. Т.к. есть надежды, что российские сети чуть лучше разбирают код 1С, возможно, обучающая выборка могла включать закрытые или редкие сегменты рунета. Сбер вообще достаточно неплохо себя показывал в начале прошлого эксперимента.

Так вот, я честно пытался. Но кроме того, что надо пройти "регистрацию, отпечаток пальца, сканер сетчатки, расписаться кровью 3 раза, продать душу дьяволу" и после этого тебе дадут к нему демо доступ на 1 час. Оно существует только в виде плагина к популярным IDE для автодополнения кода. А я не хочу автодополнения, я хочу, чтобы за меня код написали.

Итак, приступим:

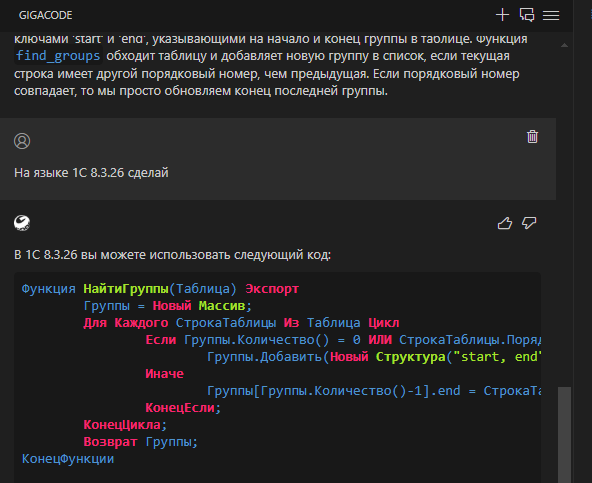

1 Сортировка массива пузырьком

Уже тут ждало разочарование - o3 и 4.1 от OpenAI справились не лучше их младшего брата. И Claude4 - не лучше, чем её младший собрат. Видимо, обучающая выборка осталась той же.

Открытые модели тоже показали себя не лучшим образом. Удивил только Grok - задача решена на ура, код на удивление красивый.

2 Метод FIFO

Claude4 тут так же на высоте, как и Claude 3.7. Такой же результат у Grok. В целом решила задачу Llama - если бы не удаление строк из таблицы значений в цикле по ней, было бы вообще прилично.

3 Цена из регистра остатков

Claude4 просто перемудрила. 3 страницы кода и пара выдуманных функций запросов не позволяют поставить ей высокую оценку. Открытые модели и GPT никак не справились с задачей. Grok опять на высоте.

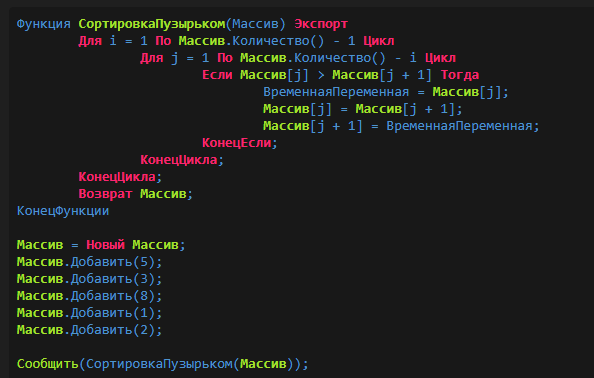

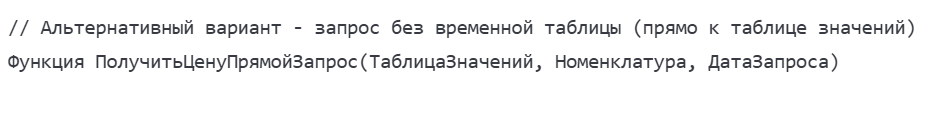

3.1 Запрос по таблице значений

Если кто не помнит - тут суть задачи такая же, что и выше, но нужно догадаться сделать запрос по таблице значений. Claude4 догадался, но вот... экзамены его сдавать не учили:

В итоге моя оценка опять средняя. Неожиданным (для меня) образом с задачей справилась Llama 4. И собственно была единственной моделью, которая решила эту задачу

3.2 Имитация "Среза последних" в запросе:

Тут прекрасно без вопросов справилась Claude. Как и младшая модель. Внезапно для меня справились GPT-шные модели. Grok решил задачу, но почему-то решил, что форматировать ответ не стоит, и выдал его простым текстом. Для сравнения, неправильный ответ предыдущего вопроса он решил отформатировать :)

На этом этапе я, очевидно, исключу из сравнения Qwen3 - потому как модель ничего не показала ни в одной из задач и для кодинга в 1С очевидно не подходит.

4 Транзитивное замыкание в запросе

Самая сложная задачка - в основном для теста на научную фантастику. С ней, конечно, никто не справился.

5 Загрузка курсов валют с сайта ЦБ РФ

Для сетей это достаточно простая задача. Справились все кроме o3. Традиционно Claude на высоте в подобных задачах.

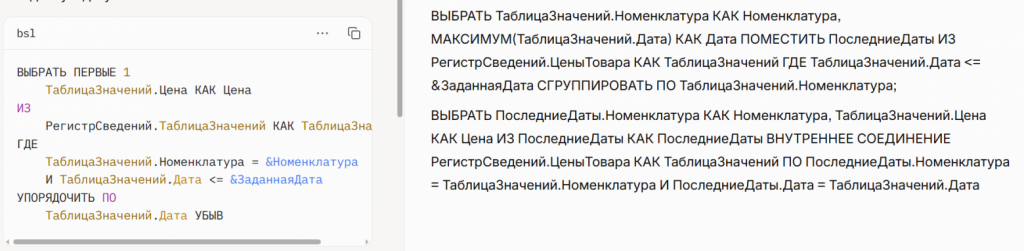

6 Загрузка из Excel

Тут сети "соревнуются" скорее в качестве кода, который они написали. Удивил cloude4.

Код действительно написан очень качественно. Вот пример начала:

Если быть честным, SpecialCells(11) я, к примеру, не написал бы.

Собственно, все остальные модели справились с этой задачей. За исключением o3. Ну и, наверное, на этом этапе o3 стоит признать неподходящей для кодинга 1С. Из дальнейшего анализа её исключаю.

7 Передача таблицы между открытыми формами

Эта, казалось бы, простая задача оказывается почему-то непосильной для сетей. Все упорно открывают форму с параметрами. Что-то неладное "почувствовал" только Grok:

Claude тоже несколько разочаровал в данной задаче, в дополнение ещё и создав ТаблицуЗначений на клиенте. Вообще 1С-ные "&НаКлиенте" и "&НаСервере" сети пока отрабатывают плоховато.

8 Выгрузка номенклатуры

Тут проверка была, догадается ли сеть про штатную сериализацию или будет костылить свою. Догадался только Grok. Claude4 закостылил свою. GPT и Llama вообще использовали COM соединение.

9 Отображение картинки на форме

Тут всё просто. Справились Llama и Grok. У остальных (включая Claude4) всё достаточно грустно. Ну единственное, конечно, у Claude неправильный, но хорошо оформленный код.

10 "РеквизитФормыВЗначение"

Для сетей это сложный тест. Прежде всего контекст задачи передать достаточно непросто. Из прошлой выборки не догадался никто. В текущей выборке опять удивил Grok.

11 Сумма по ТЧ на сервере

Тест достаточно простой. Очевидно сети справятся. Ключевая история в том, чтобы догадались, что большую табличку надо пересчитывать на сервере. Это уже существенно сложнее.

Выводы

-

С точки зрения 1С кодинга в рейтинг уверенно врывается Grok, который показал на удивление неплохие результаты. Сопоставимые с Claude (у меня получилось даже лучше) и Gemini 2.5 Pro (лишь чуть уступил).

-

Claude 3.7 и Claude 4 практически не отличимы, у меня 3.7 даже получились чуть лучшие результаты. Но тут может быть доля субъективизма. Тем не менее, очевидный вывод, что решающее значение имеет контекст обучения, а не качество модели пока что. В случае с 1С слишком мало контекста

-

GPT модели себя не оправдали совсем для 1С кодинга

-

Llama 4 действительно показывает неплохой результат, пожалуй лучший среди всех открытых моделей

Бонус. Инструменты

В предыдущей статье я писал про начало разработки инструментария для Vibe-кодинга в 1С.

Собственно, этот процесс продолжается, есть некоторые успехи:

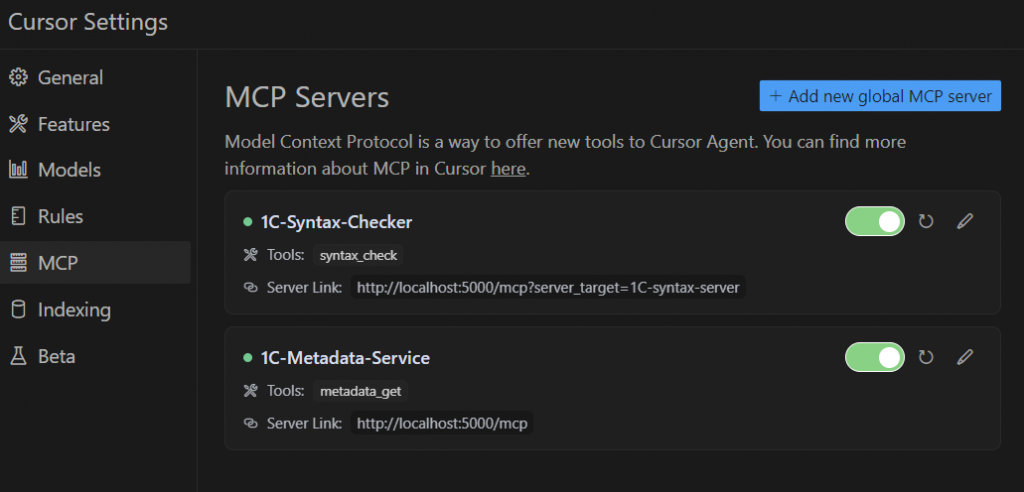

Вот так выглядит мой Cursor IDE настроенный под разработку 1С.

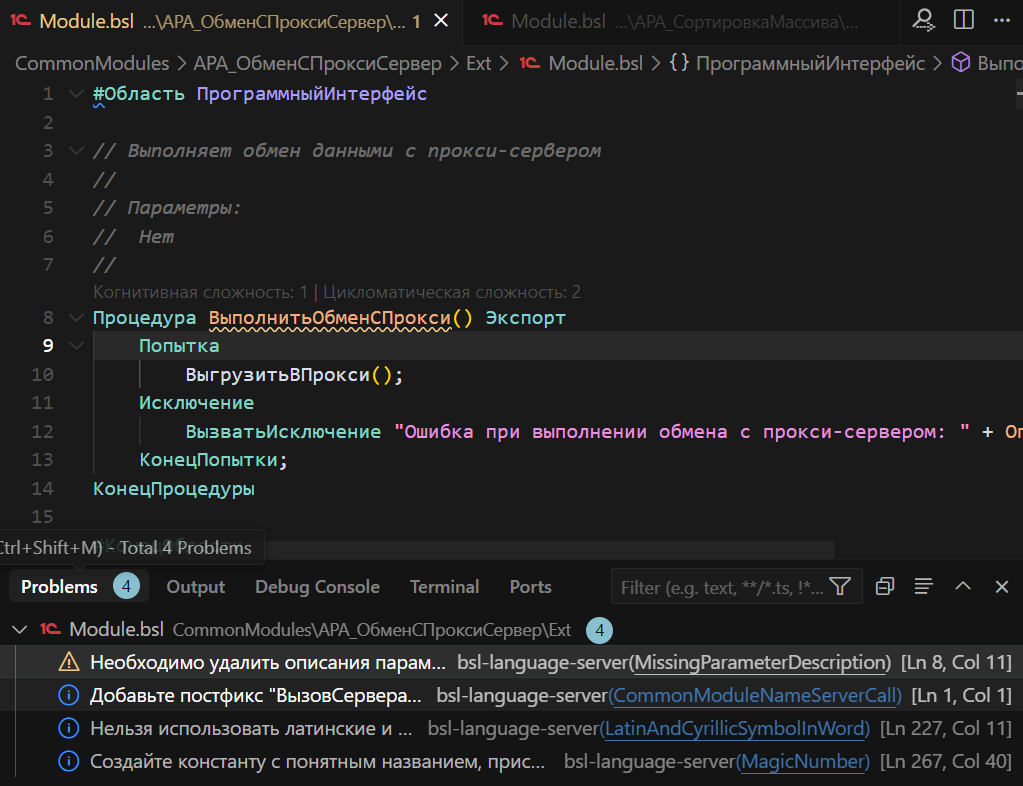

Два MCP сервера - это, конечно, основное. Один из них используется для поиска по метаданным. Второй - проверка синтаксиса. С использованием Language Server конечно. Не всё так гладко, как хотелось бы, но тем не менее.

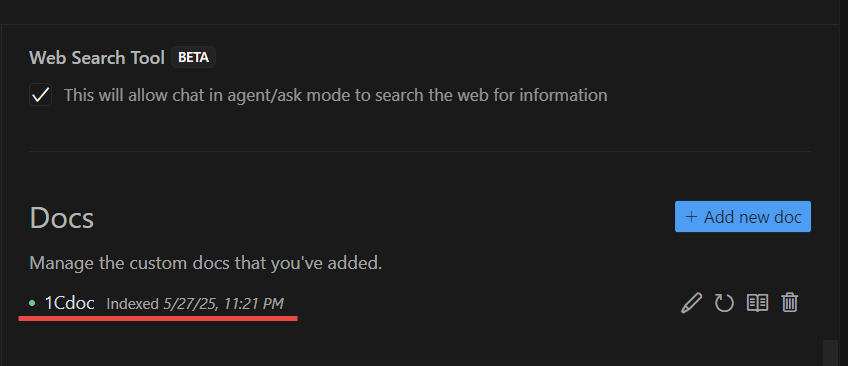

Но MCP это постфактум проверка в любом случае, так что справку для контекста ещё закинул курсору в доки:

Естественно, определены базовые правила. Вроде "Ты программист 1С, у тебя N лет опыта, ты знаешь БСП, Конфигурации.... подсистемы.... не пихай везде Сообщить(), проверяй существование методов по справке 1С" и куча прочих полезностей, которые собираются в процессе работы. Этим файлом я, несомненно, поделюсь когда будет готов его более-менее финальный вариант.

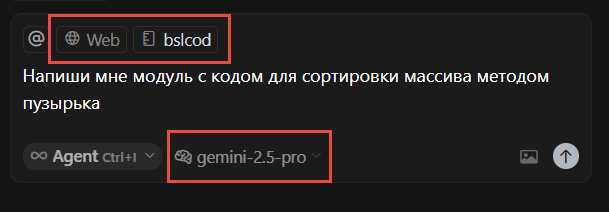

Окошко с чатом по минимуму выглядит вот так:

Здесь в явном виде выбрана Gemini-2.5-pro, как лучшая сеть для работы с 1С. Но для рядовых задач можно выбрать что-то побыстрее и попроще. Контекст обязательно должен включать Web поиск. Справку по языку 1С тоже крайне желательно.

Сам базовый плагин Language Server у меня, конечно, установлен, но доподлинно известно, что без MCP он не работает с Cursor. Вернее, Cursor ничего не знает про его проверки:

Собственно, дальше дело техники - разработка в EDT, параллельно открыт Cursor на том же каталоге. Если нужно привлечь ИИ для написания кода, переключаемся на экран с Cursor и просим, там же принимаем или не принимаем изменения. Локальный git используем для версионирования и отката косяков. В Cursor, конечно, есть встроенное... но если меняли и в нём и в EDT, то лучше git. Дебажим всё, что накодил курсор, конечно, в EDT. Формы тоже в EDT. В целом есть, конечно, идея сделать MCP для редактирования и отладки форм. Итерационный процесс можно агенту зарядить. Но пока не знаю, что получится - идея в начальной стадии проработки. Лайки, если хочется попробовать, - возможно, это ускорит разработку тулинга.

В целом платность Cursor в размере 20$ в месяц, включающая возможности использования топовых сетей для кодинга, меня более чем устраивает. Но пока в части работы с метаданным достаточно много ограничений, что не позволяет его использовать как полноценную IDE. В EDT, конечно, я провожу намного больше времени.

Что касается EDT.

Лучшее, что нашлось, пока выглядит вот так:

Что не устраивает:

-

Нет нормальных моделей

-

Нет MCP

-

Нет использования полного контекста

-

Нельзя подкинуть доки

-

Нет Web поиска

-

Достаточно скудное взаимодействие с редактором

Понятно, что Cursor для EDT мы в одночасье не напишем, но поддержка моделей, MCP, web и контекст не выглядит сверх задачей. В общем, плагин в стадии разработки. Надеюсь, в одной из следующих версий данной истории обязательно покажу.

От себя добавлю, что даже то, что пока есть, это просто лютая экономия времени. Используйте сети для кодинга, даже если это 1С.

MCP-серверы, которые передают нейросети полный контекст по 1С: метаданные, справку 1С, структуру базы, логи и документацию.

ИИ учитывает архитектуру и создаёт готовый код для типовых и проектных задач в 1C.

Поддерживает GPT-4, Llama, Claude, Gemini. Интеграция с LM Studio, Cursor IDE и EDT.

Вступайте в нашу телеграмм-группу Инфостарт