Microsoft разработала решение для защиты систем машинного обучения от взлома. Counterfit позволяет моделировать атаки на искусственный интеллект и оценивать уровень безопасности таких проектов.

Зачем нужен Counterfit

Интеллектуальные системы применяются во многих бизнес-проектах, играх и научных исследованиях, но до недавнего времени их безопасности не уделяли особого внимания. Вместе с тем хакеры научились взламывать модели, чтобы изменить поведение ИИ – и, как следствие, украсть данные или спровоцировать принятие неверного решения.

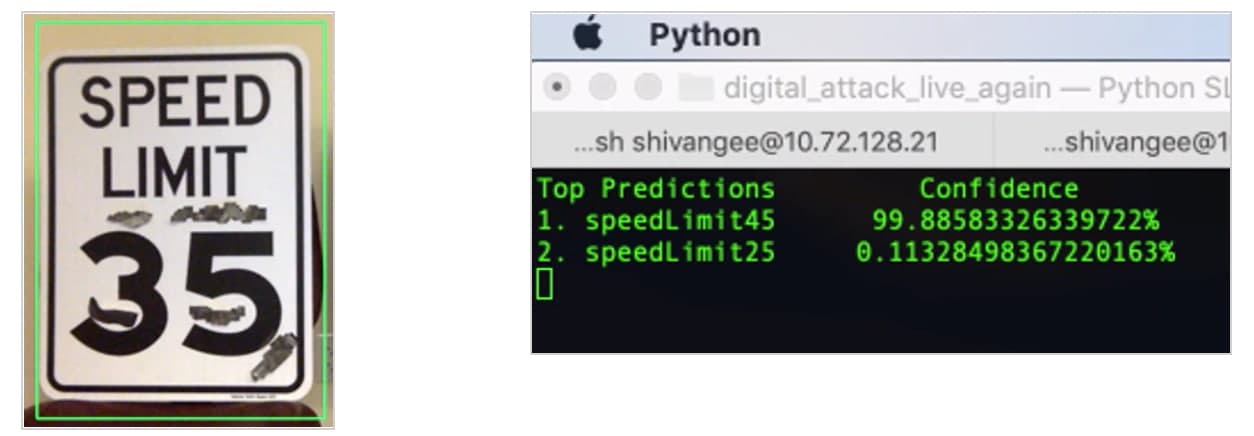

Один из недавних примеров такой атаки – взлом пакета McAfee на старых Tesla с камерами MobileEye. Наклеив полоски черного скотча на знаки ограничения скорости, хакеры смогли обмануть умную систему и заставить ее неверно истолковывать ограничения.

Знак распознаётся как ограничение 45 миль/час

Еще один случай – обман чат-бота Microsoft Tay. Злоумышленники задавали системе специально подобранные вопросы, и в результате Tay стал писать в Twitter расистские комментарии.

Counterfit – это, по сути, набор скриптов для тестирования умных систем на взлом и сканирования на предмет уязвимостей. Он отслеживает атаки на искусственный интеллект, анализирует их и предотвращает реальные попытки взлома.

Изначально Microsoft создавала Counterfit для внутренних нужд. Но со временем инженеры решили открыть доступ к инструменту для всех разработчиков.

Как работать с Counterfit

Counterfit – проект с открытым исходным кодом. Его можно загрузить из репозитория на GitHub, установить в среде Azure Shell и запустить в браузере или развернуть локально в среде Anaconda Python.

Пакет включает инструмент командной строки и функции для автоматизации моделей кибератак на системы искусственного интеллекта. С их помощью можно проверить решение на прочность в облачной среде, локально или на периферии.

В самой системе искусственного интеллекта можно использовать практически любые модели и типы данных: текст, изображения, детерминированный или потоковый ввод. Эффективность использования Counterfit от характера информации не зависит.

Текущая версия может запустить тестовые атаки сразу на несколько ИИ-моделей. Такие эксперименты должны повысить уровень надежности отдельных алгоритмов обработки данных и бизнес-систем в целом.

Специалисты консалтинговой компании Gartner заявили, что компании, которые до 2024 года внедрят средства обеспечения безопасности ИИ-систем, смогут вдвое чаще избегать негативных последствий от взлома. Это не 100% результат, но перспективная сфера для исследований и разработки.