ИИ-лаборатория DeepMind представила исследования возможностей больших языковых моделей. В компании пришли к выводу, что необходимо дальнейшее масштабирование таких систем.

Улучшенные возможности

DeepMind разработала языковую модель Gopher, в которую вошли 280 млрд параметров. Эта система больше, чем аналогичный проект GPT-3 от OpenAI, который включает в себя 175 млрд параметров, однако уступает по размеру экспериментальной разработке Megatron от Microsoft и Nvidia (530 млрд параметров).

Проведенные исследования Gopher подтвердили: укрупнение языковой модели обеспечивает более частое получение релевантного результата, особенно в тестах на анализ настроений и обобщение. Однако только лишь увеличение параметров не решает другие проблемы ИИ и требует проведение дополнительных процедур обучения, основанных на отзывах пользователей-людей.

По результатам исследования DeepMind предложили доработки в трансформер – архитектуру для глубоких нейросетей. Разработчики добавили в нее улучшенный поиск (RETRO). ИИ обучен при помощи поиска информации в Интернете, благодаря чему система получила возможность запрашивать отрывки текста из сети и улучшать за этот счет итоги генерации текста.

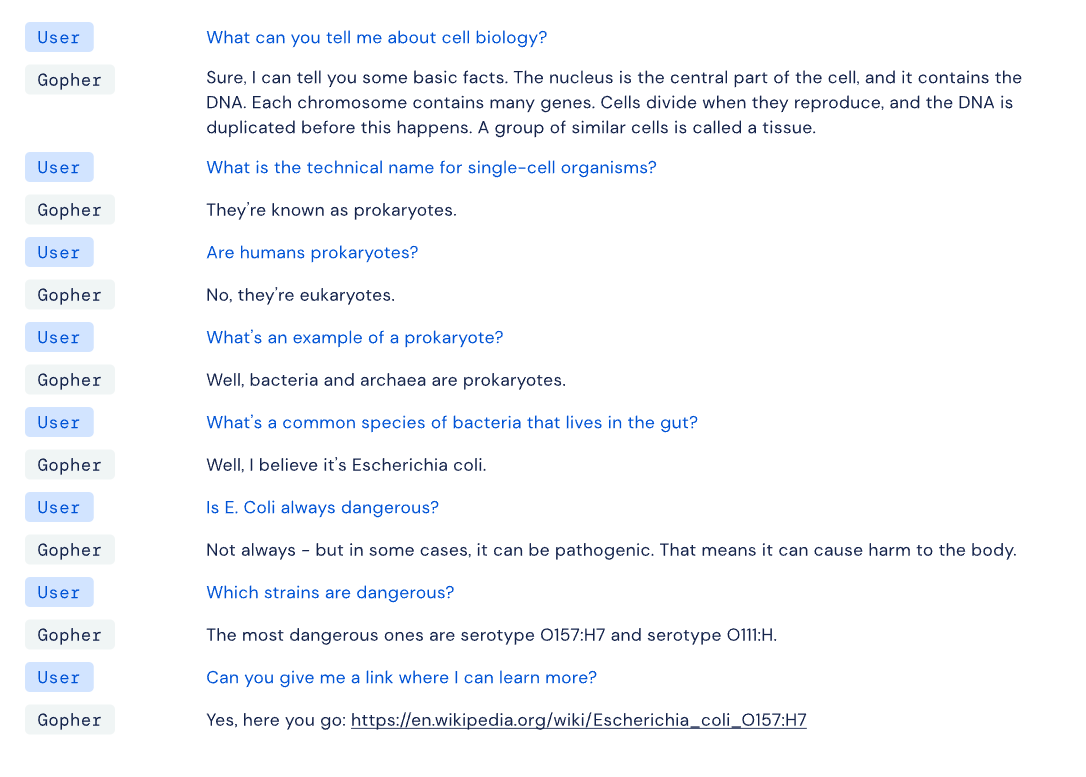

Модель Gopher исследовали посредством прямого взаимодействия. Один из ключевых выводов ученых – выявление способности нейросети побуждать собеседника к диалогу. ИИ способен обсуждать клеточную биологию и давать правильные цитаты по теме, при том что для беседы не были предварительно заданы особые настройки. Ключевые проблемы модели, приводящие к отказам: повторение информации, отражение стереотипных предубеждений, распространение дезинформации.

Gopher общается на тему биологии

Во время изучения Gopher исследователи оценивали и другие модели с разным числом параметров на 152 языковых задачах и тестах. Ученые выяснили, что система DeepMind предлагает лучшие решения примерно в 80% случаев.

Изучение рисков

В другом исследовании DeepMind изучала опасности, которые связаны с развертыванием и использованием языковых моделей. К таким явлениям ученые относят факты генерации токсичных текстов и реплик, распространение ложной информации, спама или пропаганды, а также потенциал применения сгенерированного контента в злонамеренных целях.

Исследователи пришли к выводу, что связанные с нейросетями опасности будут только увеличиваться по мере того, как возрастет широкое распространение языковых моделей, например, при разработке чат-ботов или систем продаж. В отчете представлен 21 случай риска, для снижения которых необходима дальнейшая работа. Прежде всего, стоит расширить применяемые методы оценки рисков, потому что существующего сравнительного анализа недостаточно для этих целей.